在大模型技术蓬勃发展的今天,算力资源已成为制约AI创新的关键瓶颈。无论是算法工程师的日常开发,还是高校实验室的科研工作,都面临着算力成本高、环境部署难、资源获取慢等挑战。GpuGeek凭借创新的"算力即服务"理念,构建起连接算力与应用的桥梁,让AI开发变得前所未有地简单高效。

极致开发体验

GpuGeek为用户提供了真正的"即开即用"体验。用户只需半分钟即可完成从注册到实例创建的全流程,平台内置TensorFlow、PyTorch、PaddlePaddle、Colossal-AI、DeepSpeed等主流开源框架和CUDA版本,配合集成的在线IDE工具可开启编程工作。

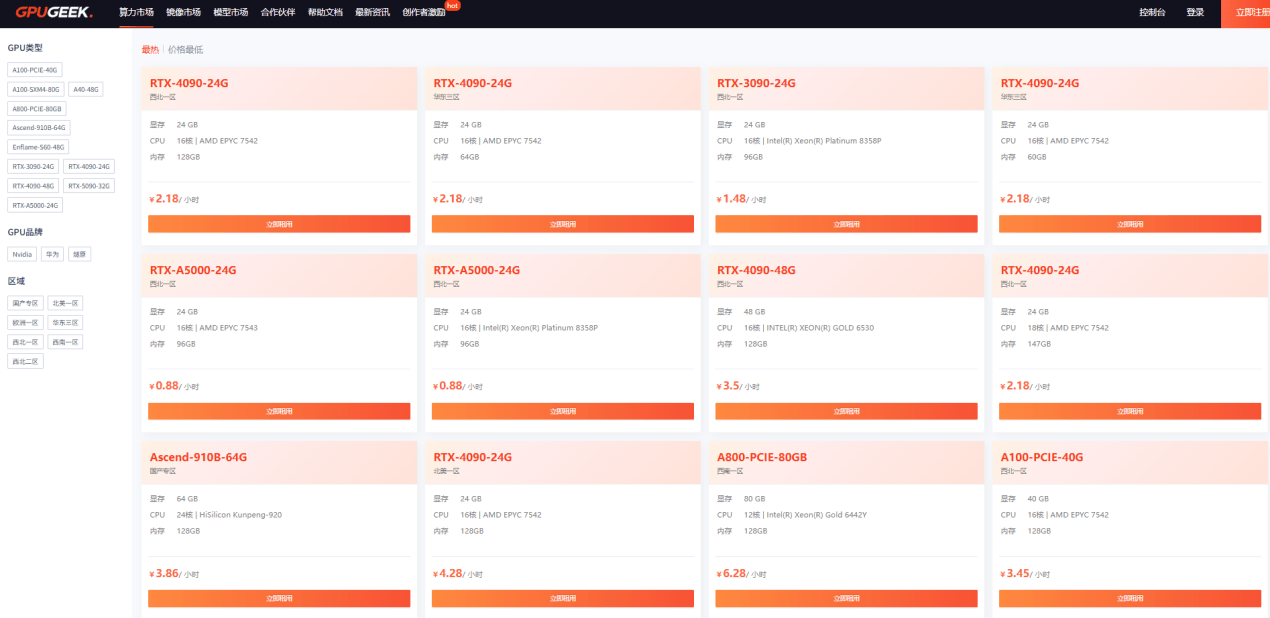

在算力资源方面,平台提供从消费级RTX 4090到专业级A5000/A40/A100,再到最新A800的全系列GPU资源。创新的按需计费模式包括包天、包周、包月及竞价等多种选择,支持秒级计费,最高可配置8卡GPU,用户还能根据需求随时切换GPU卡数且无需重新配置环境,真正实现"按需付费,高效使用"。

全球化研发生态

对于经常需要访问国外学术资源的研究人员,GpuGeek专门推出加速功能,覆盖主要学术网站,有效解决了访问卡顿的问题。平台还在全球范围内部署了多个节点,包括庆阳、宿迁、湖北等国内节点和香港、达拉斯、欧洲等海外节点,实现了模型镜像秒级加载,推理延迟低至0.5秒。

在模型资源方面,GpuGeek模型市场提供了丰富的选择。平台已经接入Qwen3-32B、智谱GLM-Z1系列、DeepSeek-V3等最新模型,用户可以便捷地进行模型体验和API调用。此外,平台还提供开源数据集供用户直接使用,并鼓励数据集共享,促进学术交流与合作。

专业科研支撑

为满足高强度研究任务的需求,GpuGeek推出了裸金属服务器方案。通过物理GPU直通技术,用户可以独占GPU资源,避免资源竞争,确保科研任务的稳定性和可靠性。这一方案特别适合需要高性能计算的科研项目,如气象模拟、基因测序等需要FP64双精度计算的任务。

值得一提的是,平台最新上线了华为昇腾910B 64G GPU资源。这款面向AI训练和推理场景的高性能处理器采用先进制程工艺和架构设计,其高带宽内存和优化的计算单元设计显著提升了数据处理效率,为大规模AI模型训练提供了新选择。

对于算法工程师和高校科研人员而言,GpuGeek不仅提供了便捷高效的开发环境,更通过全方位的技术支持和持续的服务创新,降低了AI技术应用的门槛,为科研创新提供了坚实的基础支撑。随着平台功能的不断完善和服务的持续升级,GpuGeek正成为推动AI技术发展和创新的重要助力平台。